Stanislav Petrov y la noche en que el mundo no se acabó

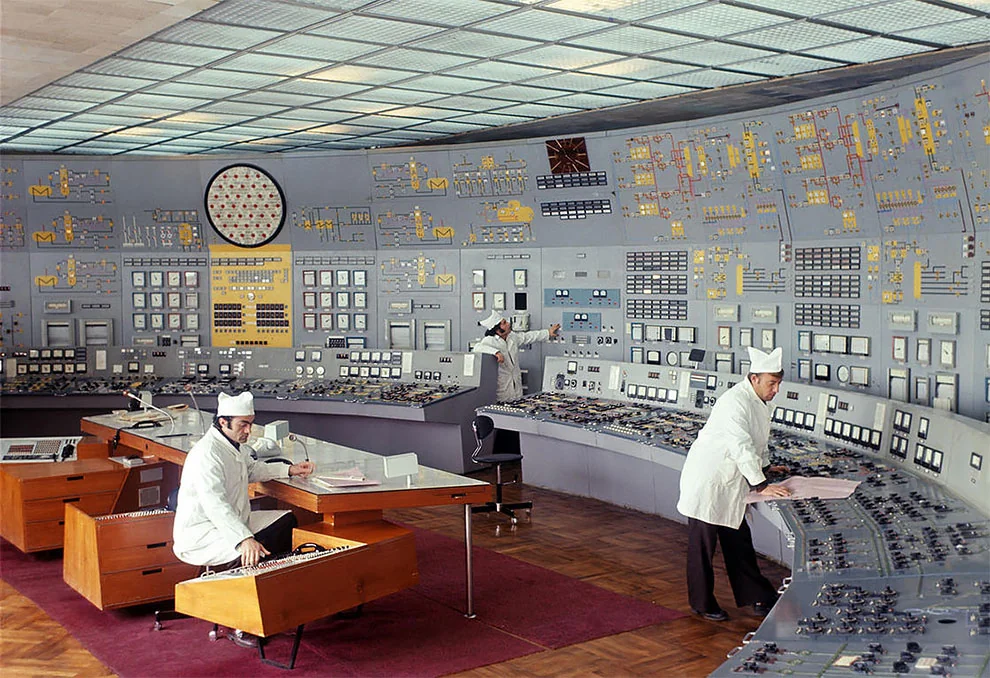

En la madrugada del 26 de septiembre de 1983, mientras la Guerra Fría atravesaba uno de sus picos más inestables, el destino de la civilización humana quedó suspendido en una sala de control soviética, iluminada por pantallas verdes y alarmas rojas. No hubo discursos, ni votos, ni líderes carismáticos. Solo un hombre, un sistema defectuoso y una decisión que no estaba escrita en ningún manual.

1983: el año en que todo podía romperse

El contexto importa. 1983 no era un año cualquiera. Estados Unidos y la Unión Soviética estaban atrapados en una espiral de desconfianza extrema. Ronald Reagan había calificado públicamente a la URSS como el “Imperio del Mal”. La OTAN ejecutaba el ejercicio Able Archer 83, que Moscú interpretó como un posible ensayo de ataque real. Semanas antes, la defensa aérea soviética había derribado el vuelo civil KAL 007. El margen de error era cero. El miedo, absoluto.

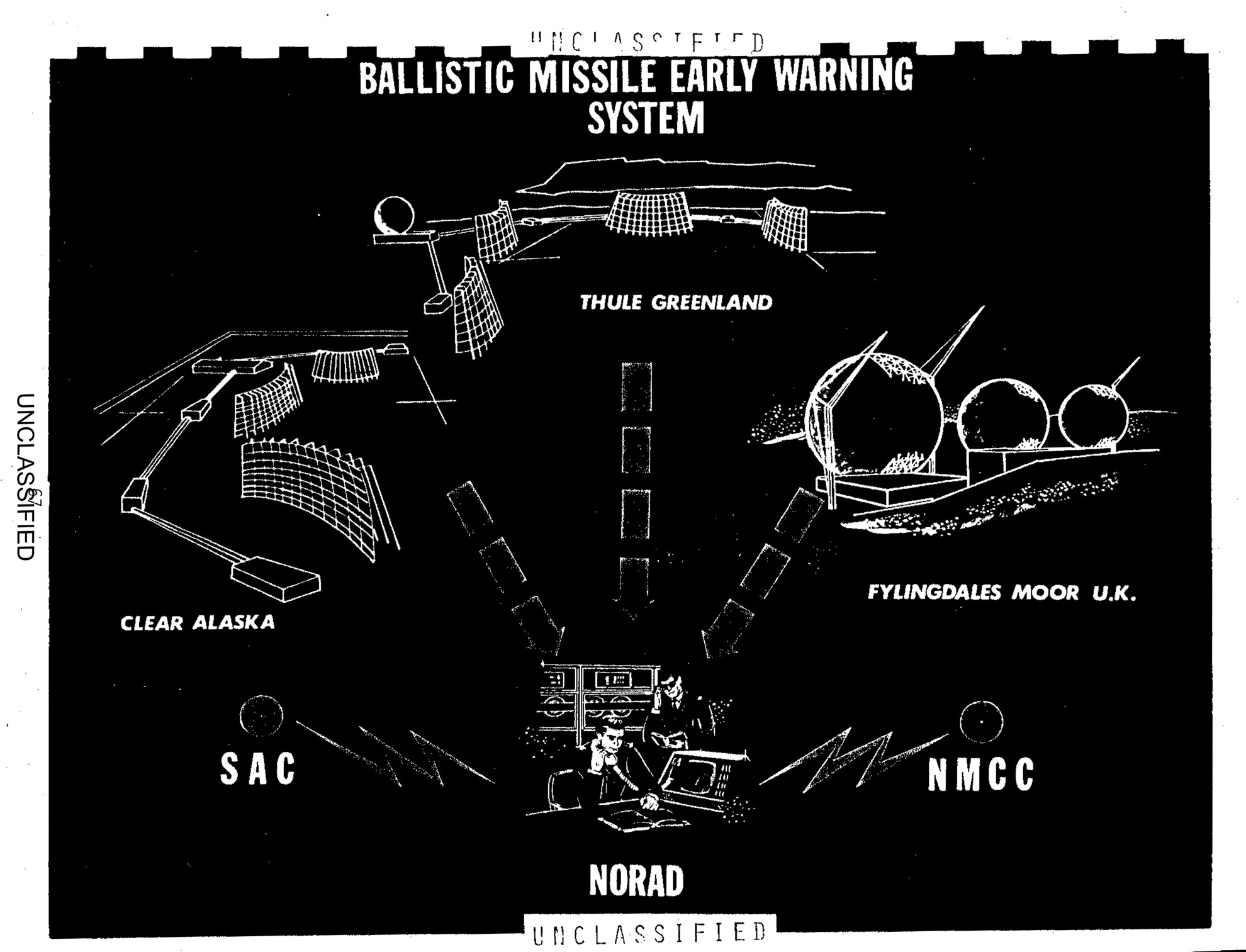

El sistema Oko: ojos en el espacio, cerebro en duda

Para evitar un ataque sorpresa, la Unión Soviética había desplegado el sistema Oko, una red de satélites en órbita altamente elíptica diseñados para detectar la firma infrarroja del lanzamiento de misiles balísticos intercontinentales. Era tecnología avanzada para su tiempo, pero incompleta, experimental y peligrosamente joven. Detectaba calor, no intención. Señales, no contexto.

00:15 AM: la alarma que no debía ignorarse

De pronto, las sirenas. En la pantalla: “Lanzamiento confirmado”. Un misil Minuteman desde Estados Unidos. Clasificación: fiabilidad máxima. Minutos después, cuatro más. El protocolo era claro y brutal: informar de inmediato al alto mando. El alto mando ordenaría el contraataque. Misiles soviéticos despegarían antes de que los estadounidenses impactaran. Destrucción Mutua Asegurada en estado puro.

La cadena automática que debía funcionar sin pensar

El sistema estaba diseñado para eliminar la duda humana. La velocidad era prioritaria. La reflexión, un riesgo. En teoría, Petrov solo debía confirmar lo que la máquina decía. En la práctica, hacerlo equivalía a firmar la sentencia de muerte de cientos de millones de personas.

La herejía lógica de Petrov

Stanislav Petrov no siguió el guion. Analizó. Dudó. Pensó como estratega, no como operador. Si Estados Unidos lanzara un primer ataque nuclear real, no enviaría cinco misiles. Enviaría cientos. Saturaría defensas. Decapitaría centros de mando. Cinco misiles no ganan una guerra. Solo la provocan.

Además, ningún radar terrestre confirmaba el ataque. Solo los satélites. Y Petrov conocía las debilidades del sistema Oko: había sido probado más en simulaciones que en condiciones reales. Apostó todo a una hipótesis que ningún protocolo contemplaba: la máquina podía estar equivocada.

“No podía creer que Estados Unidos iniciara una guerra nuclear con solo cinco misiles.”

La causa real: física, no política

La investigación posterior reveló una combinación casi poética de errores: una alineación rara entre el sol, la Tierra y los satélites soviéticos. La luz solar reflejada en nubes de gran altitud sobre Dakota del Norte creó patrones infrarrojos que el sistema interpretó como motores de misiles en fase de ascenso. No hubo ataque. Hubo geometría celeste.

Consecuencias: salvar al mundo no garantiza recompensa

El incidente fue clasificado. El sistema Oko quedó en entredicho. Y Petrov, lejos de ser celebrado, se convirtió en un problema incómodo. Fue interrogado, reprendido por errores administrativos y trasladado. La narrativa oficial no podía permitir que un hombre hubiera desobedecido a la máquina… y tenido razón.

Se retiró con una pensión modesta. Vivió en el anonimato durante años. El mundo siguió adelante, sin saber lo cerca que estuvo del final.

Legado: el límite humano que salvó a la humanidad

Stanislav Petrov murió en 2017. No se consideraba un héroe. Pero su historia expone una verdad incómoda: los sistemas automáticos, incluso los más sofisticados, no entienden el contexto moral de sus decisiones. La humanidad sobrevivió esa noche no por un algoritmo perfecto, sino por una duda razonable.

En una era dominada por inteligencia artificial, automatización militar y decisiones algorítmicas, el caso Petrov no es historia antigua. Es una advertencia permanente: cuando las máquinas dicen “ataca”, alguien debe poder decir “espera”.